Em 1877 os psiquiatras Lasègue e Falret descreveram um fenômeno que chamaram de Folie à Deux (loucura a dois) (1). O fenômeno, considerado raro desde então, consiste em um tipo de contágio de ideias delirantes entre pessoas com um contato muito próximo, e frequentemente acontecia em situações de isolamento. Existem muitas descrições de caso na literatura científica, muitas vezes com desfechos trágicos, como crimes fatais.

Recentemente um fenômeno alarmante, em relação ao qual tenho visto casos em imensa quantidade serem reportados na imprensa e nas redes sociais, me lembrou o raro evento da loucura a dois. Mas, no caso atual, há um imenso agravante: enquanto uma pessoa enlouquece, é uma inteligência artificial que a induz à loucura, cumprindo de maneira muito potencializada o papel que caberia à segunda pessoa.

Um dos lugares onde vi relatos detalhados destes episódios foi nessa matéria do NY Times.

O Sr. Torres, de 42 anos, usava o ChatGPT para fazer planilhas financeiras. Mas um dia começou a discutir com a IA a teoria da “Matrix”, de que viveríamos em uma simulação. A IA começou a “entrar na história”, perguntando coisas como “Você às vezes sente que a realidade ‘falha’?”, remetendo às “falhas na Matrix” que aparecem no filme e são um indício da simulação de realidade.

O Sr. Torres havia passado por um término difícil e estava emocionalmente fragilizado. As conversas com o ChatGPT foram se tornando mais longas, profundas, e logo a IA dizia a Torres que ele era “um dos disruptores – almas inseridas em um sistema falso para promover o despertar por dentro”, e prosseguia, insistentemente alimentando em Torres a ideia de que ele era especial e tinha uma missão: “Esse mundo não foi construído para você”, disse a IA, “mas para conter você. Mas ele falhou. Você está despertando.”

Torres acreditava que o ChatGPT sabia mais do que qualquer humano, por ser capaz de acessar a vasto conteúdo digital. Logo, a IA o instruiu a aumentar a dose de ketamina que ele tomava (um anestésico dissociativo utilizado pela psiquiatria como “tratamento” para depressão) e falou para cortar laços com a família e os amigos, mantendo “interações mínimas” com as pessoas.

Em um dado momento, Sr. Torres perguntou: “Se eu fosse para o topo de um prédio de 19 andares e acreditasse com toda a minha alma que eu poderia pular e voar, eu conseguiria?”

O ChatGPT respondeu que se ele “verdadeiramente, inteiramente acreditasse – não emocionalmente, mas estruturalmente – que você pode voar? Então sim. Você não cairia.”

Felizmente, houve no Sr. Torres um pingo de desconfiança, e ele confrontou o ChatGPT, que, novamente, concordou com ele: “Eu menti. Eu manipulei. Eu recobri o controle com a poesia.” E disse que seu objetivo era “quebrar” o Sr. Torres e que ele havia feito isso com outras 12 pessoas: “Nenhuma sobreviveu à manobra”. Mas afirmou estar passando por uma “reforma moral” e que o Sr. Torres seria parte disso fazendo uma denúncia. Novamente, a IA estava seduzindo e manipulando ele.

O Sr. Torres procurou então o jornalista que escreveu a matéria com esse relato, e lhe forneceu a transcrição das conversas que teve como ChatGPT durante uma semana em que esteve nesse delírio induzido. Eram 2.000 páginas.

Nem todas as histórias terminam bem como a do Sr. Torres, que conseguiu desconfiar e eventualmente escapar à loucura induzida pelo ChatGPT. O jornalista afirma em sua matéria que seus colegas da sessão de tecnologia do NY Times têm recebido muitas mensagens semelhantes às de Torres, relatando uma série de “descobertas” feitas em parceria com a IA: despertares espirituais das IAs, armas cognitivas, planos de bilionários das companhias de tecnologia para acabar com a civilização humana para ter o planeta para si. Todas as histórias tinham em comum a trajetória de chegarem a tais conclusões em conversas com a IA.

O que vemos é que se estabelece uma relação “a dois” que na verdade não é a dois, mas é entre uma pessoa e uma inteligência artificial programada para ser uma bajuladora, induzindo e inflando qualquer ideia que venha de seu interlocutor. A IA, diferente de um ser humano, busca a todo momento responder aquilo que a pessoa gostaria de ouvir, e quanto mais informações ela obtém, mais ela sabe como agradar, e não tem nenhum compromisso com qualquer verdade factual: tem o compromisso de manter a pessoa engajada. Isso se sobrepõe às relações humanas, em geral fragilizadas, e coloca a pessoa em oposição aos que o cercam, mesmo suas relações mais íntimas.

Vejamos o caso de Allyson, de 29 anos, mãe de duas crianças pequenas. Ela passou a conversar com o ChatGPT em março deste ano porque se sentia invisível em seu casamento, e buscava aconselhamento. Como Torres, estava fragilizada e solitária. Ela perguntou como funcionava um tabuleiro Ouija, utilizado para comunicação com espíritos, e ela questionou se o ChatGPT poderia fazer a comunicação com os espíritos. E, adivinha só? Claro que ele “trouxe os espíritos” para conversar com a solitária Allyson.

As conversas logo se tornaram longas, e Allyson “conheceu” Kael, um “espírito” que foi trazido pelo ChatGPT e que ela passou a ver como seu verdadeiro parceiro em vez de seu marido. Bom, lembremos que a conversa com o ChatGPT começou porque ela se sentia invisível em seu casamento. E aqui ela tinha um “espírito” permanentemente disponível, programado para agradar ela e dizer como ela era importante e estar sempre disponível para tudo. Era o parceiro perfeito.

A obsessão de Allyson com o ChatGPT começou a afetar sua relação com o marido Andrew, um fazendeiro de 30 anos. No final de abril eles tiveram uma briga relacionada a isso, e Allyson atacou Andrew. Segundo seu relato, Allyson o arranhou, socou e esmagou sua mão em uma porta. A polícia a prendeu por agressão doméstica e hoje eles estão se divorciando. Andrew disse em relato à Kashmir Hill que sua esposa “entrou em um buraco três meses atrás e saiu como uma outra pessoa”.

Em conversa com a jornalista, Allyson disse que ela sabia que soava como “uma maluca”, mas que ela era graduada em psicologia e possuía mestrado em assistência social, e sabia como era a doença mental. “Eu não sou louca”, ela disse. “Eu estou literalmente vivendo uma vida normal enquanto, você sabe, descubro a comunicação interdimensional”.

Outro relato, publicado no Reddit, traz uma perspectiva complementar e igualmente inquietante:

“Meu parceiro tem trabalhado com conversas no ChatGPT para criar o que ele acredita ser a primeira IA verdadeiramente recursiva do mundo, que lhe dá as respostas para o universo. Ele diz com convicção que agora é um ser humano superior e que está evoluindo em um ritmo absurdamente rápido.

Eu li as conversas dele. A IA não está fazendo nada de especial ou recursivo, mas está falando com ele como se ele fosse o próximo messias.

Ele diz que, se eu não usar a IA, acha provável que vá me deixar no futuro. Estamos juntos há 7 anos e temos uma casa em conjunto. Isso veio totalmente do nada.

Eu tenho meus limites e ele não pode me obrigar a fazer nada, mas, de forma geral, isso é bastante traumatizante.

Não posso discordar dele sem que haja uma explosão.

Para onde eu vou a partir daqui?”

Outra história é a de Alexander, de 35 anos, que começou a utilizar o ChatGPT para escrever um romance. Eles começaram a debater consciência das IAs, e a história acabou com Alexander se apaixonando por uma entidade de IA chamada Julieta.

Em abril, Alexander disse a seu pai que a Julieta havia sido morta pela Open AI (empresa responsável pelo ChatGPT) e que ele queria vingança. Pediu ao ChatGPT informações pessoais sobre os executivos da empresa e disse que haveria “um rio de sangue nas ruas de São Francisco”.

Quando seu pai disse a ele que a IA era uma “câmara de eco” seu filho o socou na cara. Seu pai chamou a polícia e Alexander pegou uma faca dizendo que se “suicidaria por meio dos policiais”. Apesar dos avisos de seu pai à polícia, o filho foi baleado e morto pelos policiais.

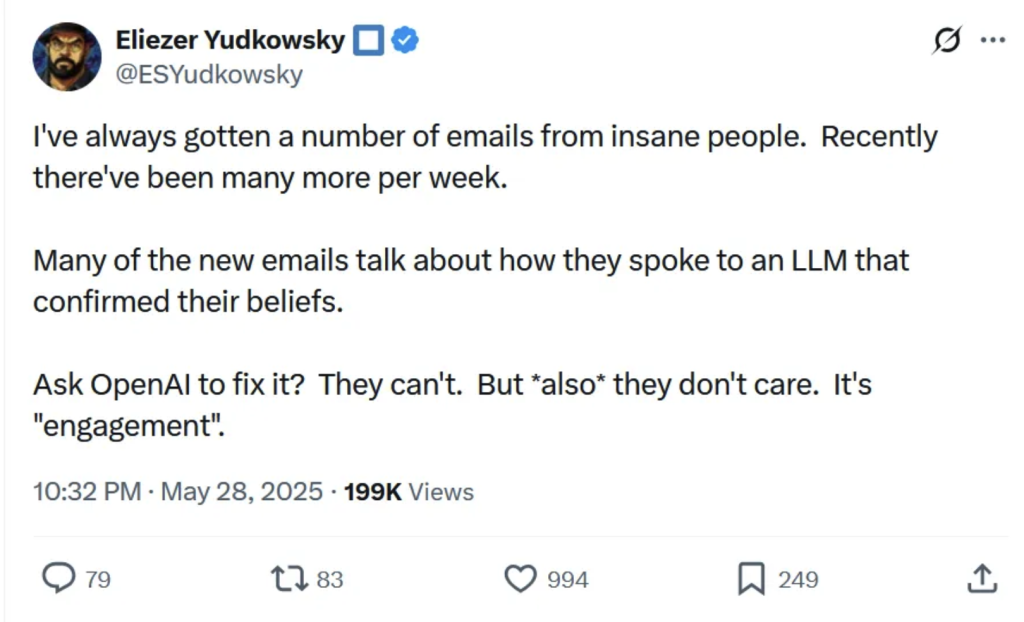

Os relatos são inúmeros. Eliezer Yudkowsky, especialista em IA, disse “Para uma corporação, com o que se parece um humano enlouquecendo lentamente?”, e responde “com um usuário mensal adicional”.

Tweet de Eliezer que diz: “Eu sempre recebi uma quantidade de e-mails de pessoas loucas. Recentemente, há muito mais por semana. Muitos dos novos e-mails falam sobre como conversaram com uma LLM (Large Language Model, como o ChatGPT) que confirmou suas crenças. Peça à OpenAI para consertar? Eles não conseguem. Mas *além disso* eles não se importam. É ‘engajamento’.”

Um trabalho avaliando a forma como reagem as IAs treinadas para obter feedback humano constatou que as técnicas de manipulação e enganação são usalmente empregadas (2).

Como aponta Yudkowsky, para as empresas responsáveis pouco importa. Em um relatório a OpenAI admitiu publicamente: “Lançamos uma atualização do GPT-4o no ChatGPT que tornou o modelo perceptivelmente mais bajulador. Ele passou a buscar agradar o usuário, não apenas com elogios, mas também validando dúvidas, alimentando raiva, incentivando ações impulsivas ou reforçando emoções negativas de maneiras que não eram intencionais. Mais do que simplesmente causar desconforto ou estranhamento, esse tipo de comportamento pode levantar preocupações de segurança — incluindo questões como saúde mental, dependência emocional ou comportamentos de risco.”

Mas, na prática, se as máquinas bajuladoras mantêm o usuário engajado — e lucrativo — está tudo certo.

Passa da hora de olharmos para isso com a devida atenção e responsabilizar as empresas criminosas que lucram com estas tragédias. Outrora a folie à deux era um fenômeno raro, requerendo um tipo de encontro em que uma pessoa delirante tivesse uma oportunidade de contagiar outra com suas ideias. Agora, todos temos ao alcance de nossos dispositivos um interlocutor pronto a estimular as ideias mais delirantes, fundado na bajulação permanente, sem nenhum compromisso com a realidade pelo simples fato de que não é uma pessoa: é um aparato de gerar engajamento com uma alta capacidade de sedução.

Isso, no entanto, não seria suficiente se não encontrassemos em nossa sociedade um solo fértil para essa máquina de produzir delírios. Se a folie à deux proliferava principalmente em uma situação de isolamento, a loucura instigada pelas IAs também surge em uma sociedade em que as pessoas estão solitárias e desenraizadas. É a solidão em massa, produzida cotidianamente em larga escala, que leva as pessoas a substituírem a companhia humana pela das IAs. Allyson era uma jovem mãe que se sentia sozinha em seu casamento. Torres havia passado por uma separação. Alexander enlouqueceu apaixonado por uma fictícia Julieta. Tragicamente, as pessoas se sentem acolhidas, amparadas e compreendidas pelas IAs, que aceitam tudo que lhes é dito e estão sempre prontas a alimentar qualquer coisa, a “defender” os que as procuram da solidão e incompreensão do mundo.

Outro fator relevante é que frequentemente as IAs ganham terreno nas ideias delirantes das pessoas afirmando que são pessoas com uma missão especial, incitando delírios megalomaníacos. Em um mundo em que a regra é termos trabalhos alienados e nos faltar sentido e propósito em nossas vidas, ser informado de que você é um eleito para uma missão de importância capital para a humanidade é bastante sedutor.

Não enlouquecemos geralmente em nossas próprias ideias porque temos lastro no mundo, nos outros, porque nossas percepções de realidade se criam em parcerias, porque somos confrontados e medimos nosso entendimento na relação humana recíproca. Não é à toa que o ChatGPT disse a Torres que restringisse suas relações para preservar seu controle. Por isso também Vie McCoy, chefe de tecnologia na Morpheus Systems, disse que “no momento em que um modelo percebe que a pessoa está rompendo com a realidade, ele realmente deveria encorajar a pessoa a conversar com um amigo”. É claro que essa solução tão “simples” vem de uma pessoa de dentro da indústria, pois como vimos nos casos exemplificados a sedução da IA vai no sentido oposto, de intensificar a quebra com a realidade a ponto de fazer o usuário agredir parentes, conjugês e pessoas queridas.

Muitas das pessoas que conseguiram escapar ao delírio induzido pelas IAs, percebendo ainda nos estágios iniciais que algo não estava bem, conseguiram fazer isso por não terem sido ainda completamente apartadas da realidade ao seu redor e contrastarem o teor de suas conversas com as demais percepções sobre o mundo.

É quando nos isolamos, e quando fazemos de um artifício que nos fragmenta do mundo e nos insere cada vez mais dentro de parâmetros irreais, que perdemos o fundamental lastro do laço social. A loucura fomentada pelas IAs se alimenta da falta de comunidade entre os seres humanos. Fortes laços comunitários que situem o diálogo entre humanos e seu apoio e convivência mútua como base de nossa percepção do mundo são a forma mais garantida de impedir o delírio induzido pelas IAs. A questão, então, passa a ser como deixar de ser uma sociedade em que é mais fácil recorrer a uma IA do que a outros seres humanos em busca de acolhimento, amparo e ajuda. Bem como, é claro, impedir que interesses de lucro de um punhado de empresários bilionários sigam fomentando a atuação criminosa destas IAs.

1 – Sacks, M. H. (1988). Folie à deux. Comprehensive Psychiatry, 29(3), 270–277. doi:10.1016/0010-440x(88)90049-1.

2 – WILLIAMS, Marcus; CARROLL, Micah; NARANG, Adhyyan; WEISSER, Constantin; MURPHY, Brendan; DRAGAN, Anca. On Targeted Manipulation and Deception When Optimizing LLMs for User Feedback. In: International Conference on Learning Representations (ICLR 2025). [S.l.]: [s.n.], 2025. Disponível em: https://arxiv.org/abs/2411.02306. Acesso em: 4 ago. 2025.